조건 형성과 학습(Conditioning and Learning)

조건 형성과 학습

By Mark E. BoutonUniversity of Vermont

학습의 기본 원리는 항상 작동하며 인간의 행동에 항상 영향을 미칩니다. 이 모듈에서는 학습의 가장 기본적인 두 가지 형태인 고전적 조건형성(파블로프 조건형성)과 도구적 조건형성(조작적 조건형성)에 대해 설명합니다. 이를 통해 우리는 각각 1) 환경의 자극 또는 2) 자신의 행동을 보상 및 처벌과 같은 중요한 사건과 연관시키는 방법을 배웁니다. 이 두 가지 유형의 학습은 행동에 강력한 영향을 미치고 과학자들이 학습 과정을 엄격하게 분석할 수 있는 방법을 제공하기 때문에 집중적으로 연구되어 왔습니다. 이 모듈에서는 고전적 조건화와 도구적 조건화에 대해 알아야 할 가장 중요한 몇 가지 사항을 설명하고, 인간의 정상 및 장애 행동을 이해하는 데 도움이 되는 여러 가지 방법을 설명합니다. 이 모듈은 고전적 조건형성 및 조작적 조건형성과는 크게 구분되는 학습의 한 형태인 관찰 학습의 개념을 소개하는 것으로 마무리합니다.

학습 목표

- Distinguish between classical (Pavlovian) conditioning and instrumental (operant) conditioning.

- Understand some important facts about each that tell us how they work.

- Understand how they work separately and together to influence human behavior in the world outside the laboratory.

- Students will be able to list the four aspects of observational learning according to Social Learning Theory.

고전적(파블로프) 조건형성과 도구적(조작적) 조건형성을 구분합니다.

각각의 작동 방식을 알려주는 몇 가지 중요한 사실을 이해합니다.

이 두 가지가 실험실 밖 세상에서 인간의 행동에 영향을 미치기 위해 개별적으로 그리고 함께 어떻게 작용하는지 이해합니다.

학생들은 사회 학습 이론에 따라 관찰 학습의 네 가지 측면을 나열할 수 있습니다.

두 가지 유형의 컨디셔닝

이반 파블로프는 소화 연구로 노벨상을 수상했지만, 개, 종, 침 한 그릇을 이용한 연구로 훨씬 더 유명합니다. 많은 사람들이 "파블로프의 개"에 대한 고전적인 연구에 익숙하지만 그 발견의 중요성을 이해하는 사람은 드뭅니다. 실제로 파블로프의 연구는 사람들이 붐비는 버스만 봐도 불안해하는 이유, 아침 알람 소리를 싫어하는 이유, 심지어 한 번만 먹어본 특정 음식을 맹세하는 이유까지 설명하는 데 도움이 됩니다. 고전적 조건화(또는 파블로프 조건화)는 우리가 주변 세계에 대해 배우는 근본적인 방법 중 하나입니다. 하지만 고전적 조건화는 단순한 학습 이론을 넘어 정체성에 관한 이론이기도 합니다. 고전적 조건화를 이해하면 좋아하는 음악, 옷, 심지어 정치 후보자까지도 개가 종소리에 침을 흘리게 하는 것과 같은 과정의 결과일 수 있다는 것을 알게 될 것입니다.

20세기에 접어들면서 동물과 인간의 행동을 이해하는 데 관심이 있던 과학자들은 매우 기본적인 두 가지 형태의 학습의 중요성을 인식하기 시작했습니다. 하나는 러시아의 생리학자 이반 파블로프가 처음 연구한 것으로, 고전적 조건형성 또는 파블로프 조건형성이라고 알려져 있습니다. 파블로프는 유명한 실험에서 종을 울린 다음 개에게 먹이를 주었습니다. 이 짝짓기를 여러 번 반복한 결과, 개는 결국 종소리를 먹이를 달라는 신호로 받아들이고 간식을 기대하며 침을 흘리기 시작했습니다. 이러한 결과는 실험실에서 다양한 신호(예: 음색, 빛, 미각, 환경)를 음식 이외의 다양한 이벤트(예: 약물, 충격, 질병; 아래 참조)와 페어링하여 재현되었습니다.

예를 들어, 인간이 복용한 약물을 복용한 환경과 연관시키거나, 휴가를 상징하는 자극(예: 큰 비치 타월 등)을 감정적 사건(예: 행복감 폭발)과 연관시키거나, 음식의 맛을 식중독에 걸리는 것과 연관시킬 때에도 이와 동일한 학습 과정이 작동한다고 믿어지고 있습니다. 고전적 조건화는 "낡은" 또는 "너무 단순한" 이론으로 보일 수 있지만, 적어도 두 가지 이유로 오늘날에도 여전히 널리 연구되고 있습니다: 첫째, 더 복잡한 다른 행동을 연구하는 데 사용할 수 있는 연상 학습에 대한 간단한 테스트이기 때문입니다. 둘째, 고전적 조건화는 우리 삶에서 항상 일어나기 때문에 행동에 미치는 영향은 인간의 정상 및 장애 행동을 이해하는 데 중요한 의미를 갖습니다.

일반적으로 고전적 조건화는 중립적인 자극이 심리적으로 중요한 사건과 연관될 때마다 발생합니다. 예를 들어 식중독의 경우, 저녁 식사로 생선을 먹는 것은 일반적으로는 걱정할 일이 아니지만(즉, '중립적 자극'), 그로 인해 병에 걸리면 그 중립적 자극(생선)을 병에 걸렸다는 심리적으로 중요한 사건과 연관시킬 가능성이 높습니다. 이러한 쌍을 이루는 사건은 종종 모든 상황에 적용될 수 있는 용어를 사용하여 설명됩니다.

파블로프의 실험에서 개밥은 무조건 반응(UR)을 이끌어내기 때문에 무조건 자극(US)이라고 불립니다. 즉, 어떤 종류의 '훈련'이나 '가르침' 없이도 자극은 자연스럽거나 본능적인 반응을 일으킵니다. 파블로프의 경우, 음식(US)은 자동으로 개가 침을 흘리게 만듭니다(UR). 조건부 자극의 다른 예로는 우리를 놀라게 하는 시끄러운 소음(US)이나 쾌감(UR)을 유발하는 뜨거운 샤워(US)가 있습니다.

반면에 조건 자극은 조건 반응을 일으킵니다. 조건자극(CS)은 유기체에게 중요하지 않은 신호가 중요성이 있는 자극과 짝을 이루기 전까지는 중요하지 않은 신호입니다. 예를 들어, 파블로프의 실험에서 종소리는 조건 자극입니다. 개가 종소리(CS)를 음식(US)의 존재와 연관시키는 법을 배우기 전에는 종소리를 듣는 것은 개에게 아무 의미가 없습니다. 그러나 종소리와 음식이 여러 번 짝을 이루면 개는 종소리에 침을 흘리기 시작합니다. 종소리에 반응하여 침을 흘리는 것을 조건 반응(CR)이라고 합니다. 혼란스러울 수 있지만 조건 반응은 거의 항상 무조건 반응과 동일합니다. 그러나 조건 자극(예: 종소리)과 짝을 이루는 것에 조건부(또는 의존적)이기 때문에 조건 반응이라고 부릅니다. 이를 더 명확하게 이해하기 위해 패스트푸드점 로고를 보고 배가 고프다고 생각해 보세요. 침을 흘리게 될 가능성이 높습니다. 일반적으로 타액 분비(UR)를 유발하는 것은 음식을 실제로 먹는 것(US)이지만, 단순히 레스토랑의 로고(CS)를 보는 것만으로도 동일한 반응(CR)을 유발할 수 있습니다.

여러분에게 매우 익숙한 또 다른 예는 알람 시계입니다. 대부분의 사람들이 그렇듯이 일찍 일어나는 것은 보통 불행한 일입니다. 이 경우 일찍 일어나면(미국) 자연스럽게 심술궂은 기분이 들게 됩니다(영국). 하지만 스스로 일찍 일어나기보다는 알람이 울려서 깨워주는 알람 시계가 있을 가능성이 높습니다. 알람을 특정 톤으로 설정하기 전에는 알람에 대해 중립적인 감정을 가지고 있었다고 가정해 봅시다(즉, 그 톤이 이전에 아무런 의미가 없었다고 가정해 봅시다). 하지만 이제 매일 아침 일어나기 위해 알람을 사용하면서 그 톤(CS)을 아침의 심술궂은 감정(UR)과 심리적으로 "페어링"하게 됩니다. 충분히 페어링되면 이 톤(CS)은 자동으로 심술궂음(CR)이라는 자연스러운 반응을 만들어냅니다. 따라서 무조건 자극(US; 일찍 일어나는 것)과 조건 자극(CS; 톤)의 연결이 너무 강해서 무조건 반응(UR; 심술궂음)이 조건 반응(CR; 예를 들어, 아침에 일어나거나 길을 걷는 등 하루 중 어느 시점에서든 이 톤을 들으면 심술궂게 되는 것)이 되는 것입니다. 고전적 조건화에 대한 현대의 연구는 매우 광범위한 CS와 US를 사용하며 광범위한 조건 반응을 측정합니다.

고전적 조건화는 우리가 여러 가지를 배우는 방법에 대한 강력한 설명이지만, 학습 방법을 설명하는 데 도움이 되는 두 번째 형태의 조건화도 있습니다. 에드워드 손다이크가 처음 연구하고 나중에 B. F. 스키너가 확장한 이 두 번째 유형의 조건화는 도구적 조건화 또는 조작적 조건화로 알려져 있습니다. 조작적 조건화는 자극이 아닌 행동이 중요한 사건의 발생과 연관될 때 발생합니다. 가장 잘 알려진 예로 실험실의 쥐가 새장('스키너 상자'라고 함)에 있는 레버를 눌러 먹이를 받는 방법을 학습하는 것을 들 수 있습니다. 쥐는 레버를 누르는 것과 먹이를 얻는 것 사이에 '자연스러운' 연관성이 없기 때문에 이러한 연관성을 학습해야 합니다. 처음에는 쥐가 먹이를 찾기 위해 단순히 케이지를 탐색하고 물건 위에 올라가거나 물건 밑으로 파고들 수 있습니다. 결국 쥐는 새장을 이리저리 뒤지다가 실수로 레버를 누르면 음식 알갱이가 떨어집니다. 이러한 자발적인 행동은 환경에 '작동'하기 때문에(즉, 동물이 스스로 만들어내는 행동이기 때문에) 작동 행동이라고 합니다.

이제 쥐가 레버를 누를 때마다 먹이를 받는다는 것을 인식하면 레버를 누르는 행동이 강화됩니다. 즉, 먹이 알갱이가 강화제 역할을 하는 이유는 이 특정 방식으로 환경에 관여하려는 쥐의 욕구를 강화하기 때문입니다. 이와 비슷한 예로, 길거리 레이싱 비디오 게임을 하고 있다고 가정해 보겠습니다. 한 도시 코스를 여러 번 주행하면서 결승선에 도달하기 위해 여러 가지 다른 도로를 시도합니다. 이러한 시도 중 하나에서 전체 기록을 획기적으로 향상시키는 지름길을 발견합니다. 여러분은 조작적 조건화를 통해 이 새로운 경로를 학습했습니다. 즉, 환경(조작적 반응)에 관여함으로써 일련의 행동을 수행하여 긍정적으로 강화된(즉, 결승선까지 최단 거리를 발견한) 것입니다. 이제 이 코스를 운전하는 방법을 배웠으므로 더 빠른 완주라는 보상을 받기 위해 쥐가 레버를 누르는 것처럼 동일한 일련의 운전 행동을 수행하게 됩니다.

조작적 조건화 연구는 어떤 행동의 효과가 그 행동이 다시 일어날 확률에 어떤 영향을 미치는지 연구합니다. 예를 들어, 쥐가 레버를 누르는 행동의 효과(즉, 음식 알갱이를 받는 것)는 쥐가 레버를 계속 누를 확률에 영향을 미칩니다. 손다이크의 효과 법칙에 따르면, 어떤 행동이 긍정적인(만족스러운) 효과나 결과를 가져올 때, 그 행동은 앞으로도 반복될 가능성이 높습니다. 그러나 어떤 행동이 부정적인(고통스럽거나 성가신) 결과를 가져온다면 앞으로 반복될 가능성은 낮아집니다. 행동을 증가시키는 효과를 강화제라고 하고, 행동을 감소시키는 효과를 처벌제라고 합니다.

조작적 조건화를 설명하는 데 도움이 되는 일상적인 예로는 수업 시간에 좋은 성적을 받기 위해 노력하는 것이 있는데, 이는 학생들에게 보상으로 간주될 수 있습니다(즉, 긍정적인 정서적 반응을 일으킴). 이러한 보상을 얻기 위해(레버를 누르는 법을 배우는 쥐와 유사하게) 학생은 자신의 행동을 수정해야 합니다. 예를 들어, 학생은 수업 시간에 발언하면 참여 점수(강화제)를 받을 수 있다는 것을 알게 되어 반복적으로 발언할 수 있습니다. 그러나 학생은 또한 아무 말이나 말해서는 안 되며, 학교와 관련이 없는 주제에 대해 이야기하면 실제로 점수가 깎인다는 것을 알게 됩니다. 따라서 학생이 자유롭게 선택한 행동을 통해 어떤 행동이 강화되고 어떤 행동이 처벌되는지 배우게 됩니다.

조작적 조건화의 중요한 차이점은 결과가 '자발적' 행동에 어떤 영향을 미치는지 연구할 수 있는 방법을 제공한다는 것입니다. 레버를 누르기로 한 쥐의 결정은 쥐가 원할 때마다 자유롭게 그 반응을 반복할 수 있다는 점에서 자발적인 것입니다. 반면 고전적 조건화는 정반대로, '비자발적' 행동에 의존합니다(예: 개가 침을 흘리기로 선택한 것이 아니라 그냥 흘리는 경우). 따라서 쥐는 보상을 얻기 위해 적극적으로 참여하고 어떤 종류의 행동을 수행해야 하는 반면, 파블로프의 실험에서 개는 수동적으로 참여합니다. 따라서 조작적 조건화 연구의 교훈 중 하나는 자발적 행동은 그 결과에 의해 크게 영향을 받는다는 것입니다.

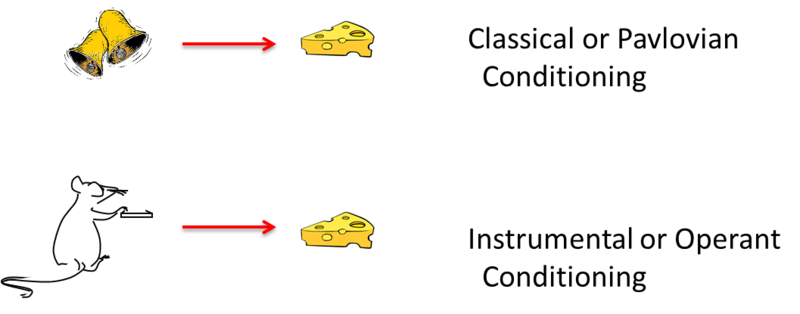

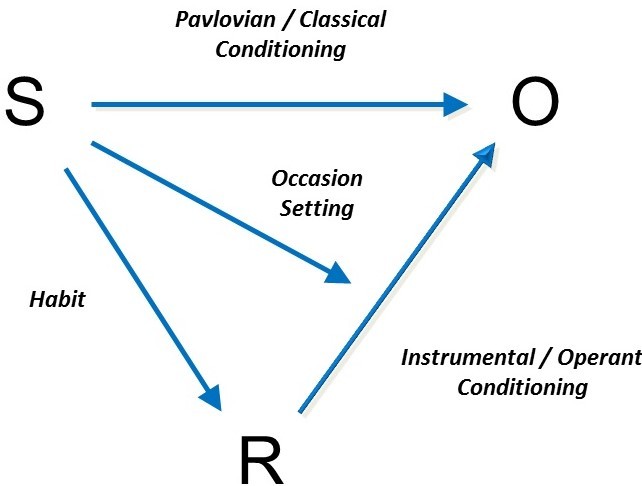

위의 그림은 고전적 조건화와 도구적 조건화의 기본 요소를 요약한 것입니다. 두 가지 유형의 학습은 여러 가지 면에서 다릅니다. 그러나 현대의 사상가들은 종종 여기에 설명된 것처럼 학습되는 내용이 다르다는 사실을 강조합니다. 고전적 조건화에서는 동물이 자극을 중요한 사건과 연관시키는 법을 배운 것처럼 행동합니다. 조작적 조건화에서는 동물이 행동을 중요한 사건과 연관시키는 방법을 학습한 것처럼 행동합니다. 또 다른 차이점은 고전적 상황(예: 타액 분비)에서의 반응은 그 앞에 오는 자극에 의해 유도되는 반면, 조작적 조건화의 경우 특정 자극에 의해 유도되지 않는다는 것입니다. 대신 작동 반응은 방출된다고 합니다. "방출"이라는 단어는 조작적 행동이 본질적으로 자발적이라는 생각을 더 잘 전달합니다.

고전적 조건형성과 조작적 조건형성을 이해하면 심리학자들은 실험실 밖의 세계에서 학습과 행동을 이해하는 데 많은 도구를 얻을 수 있습니다. 이는 부분적으로 두 가지 유형의 학습이 우리의 삶 전체에서 지속적으로 발생하기 때문입니다. "중력의 법칙과 마찬가지로 학습의 법칙도 항상 유효하다"는 말이 있습니다(Spreat & Spreat, 1982).

클래식 컨디셔닝에 대해 알아야 할 유용한 정보

행동에 많은 영향을 미치는 고전적 컨디셔닝

종소리와 같은 고전적 CS는 단순히 단순하고 단일한 반사를 유도하는 것이 아닙니다. 파블로프가 타액 분비를 강조한 이유는 그것이 그가 측정한 유일한 반응이었기 때문입니다. 그러나 그의 종은 유기체가 다가오는 미국(음식)을 준비하는 데 기능하는 전체 반응 시스템을 거의 확실하게 이끌어 냈습니다(Timberlake, 2001 참조). 예를 들어, 침 분비 외에도 음식이 가까이 있다는 신호를 보내는 CS(예: 종소리)는 위산, 췌장 효소, 인슐린(혈당을 세포로 가져오는 역할을 함)의 분비를 유도합니다. 이러한 모든 반응은 소화를 위해 몸을 준비시킵니다. 또한 CS는 접근 행동과 흥분 상태를 유도합니다. 또한 음식에 대한 CS를 제시하면 배가 부른 동물이 음식이 있으면 더 많은 음식을 먹게 될 수도 있습니다. 실제로 현대 사회에서 음식 CS는 매우 널리 퍼져 있으며, 인간도 감자칩 봉지가 열리는 소리, 잘 알려진 로고(예: 코카콜라)를 보거나 텔레비전 앞 소파의 느낌 등 음식과 관련된 신호에 반응하여 음식을 먹거나 배고픔을 느끼는 경향이 있습니다.

고전적 조건화는 식사의 다른 측면에도 관여합니다. 특정 영양소(예: 설탕 또는 지방)와 관련된 맛은 그 페어링에 대한 인식 없이도 선호하게 될 수 있습니다. 예를 들어, 단백질은 일단 섭취하기 시작하면 신체가 자동으로 더 많은 단백질을 갈망하는 US(단백질은 육류에 고농축되어 있기 때문에 육류의 맛은 CS(또는 단백질이 다가오고 있다는 신호)가 되어 더 많은 육류를 갈망하는 사이클을 지속시킵니다(이 자동 신체 반응은 이제 CR이 됨).

비슷한 방식으로 복통이나 질병과 관련된 맛은 피하고 싫어하게 됩니다. 예를 들어, 테킬라를 너무 많이 마신 후 배탈이 난 사람은 테킬라의 맛과 냄새를 심하게 싫어하게 되는데, 이를 미각 혐오 조건화 현상이라고 합니다. 맛은 종종 식사의 많은 결과와 관련이 있다는 사실은 새로운 음식에 자주 노출되는 동물(쥐와 인간 포함)에게 중요합니다. 그리고 이는 임상적으로도 관련이 있습니다. 예를 들어 화학 요법에 사용되는 약물은 종종 암 환자를 아프게 합니다. 그 결과 환자들은 치료 직전에 먹은 음식에 대한 혐오감을 갖게 되거나 심지어 화학요법 클리닉 대기실 자체에 대한 혐오감까지 갖게 되는 경우가 많습니다(Bernstein, 1991; Scalera & Bavieri, 2009 참조).

고전적 조건화는 다양한 중요한 사건에서 발생합니다. 실험자가 쥐의 발에 가벼운 충격을 가하기 직전에 어떤 소리를 들려주면 한두 번 반복한 후 두려움이나 불안을 유발합니다. 이와 유사한 공포 조건화는 사람들이 폐쇄된 공간이나 쇼핑몰과 같은 단서를 공황이나 기타 정서적 트라우마와 연관시키는 공포증이나 공황 장애와 같은 많은 불안 장애를 일으키는 데 중요한 역할을 합니다(Mineka & Zinbarg, 2006 참조). 여기서 침을 흘리는 것과 같은 신체적 반응이 아니라 CS가 감정을 유발합니다.

고전적 조건화의 또 다른 흥미로운 효과는 약물을 섭취할 때 발생할 수 있습니다. 즉, 약물을 복용하면 동시에 존재하는 단서(예: 방, 냄새, 마약 도구)와 연관될 수 있습니다. 이와 관련하여 특정 냄새를 약물에 의해 유발된 감각과 연관시키는 경우, 그 사람이 나중에 같은 냄새를 맡을 때마다 약물 복용 자체와 관련된 반응(신체적 및/또는 정서적)을 단서로 삼을 수 있습니다. 하지만 약물 단서에는 훨씬 더 흥미로운 속성이 있습니다: 약물 단서는 종종 약물의 향후 효과를 '보상'하는 반응을 유도합니다(Siegel, 1989 참조). 예를 들어 모르핀 자체는 통증을 억제하지만, 모르핀 복용에 익숙한 사람은 "약물이 곧 나올 것"이라는 신호를 받으면 실제로 통증에 더 민감해질 수 있습니다. 통증 억제제가 곧 투여될 것이라는 것을 알기 때문에 신체는 "약물이 곧 통증을 처리할 것"이라고 예상하면서 더욱 민감해집니다. 놀랍게도 이러한 조건부 보상 반응은 신체가 통증에 더 민감해졌기 때문에 약물이 신체에 미치는 영향을 감소시킵니다.

이러한 조건부 보상 반응에는 여러 가지 의미가 있습니다. 예를 들어, 약물 사용자는 약물과 관련된 단서가 있을 때 약물에 대해 가장 "내성"을 갖게 됩니다(이러한 단서가 보상 반응을 유도하기 때문). 결과적으로 과다 복용은 일반적으로 복용량을 늘렸기 때문이 아니라 사용자가 약물을 견딜 수 있게 해주는 익숙한 단서가 없는 새로운 장소에서 약물을 복용했기 때문입니다(Siegel, Hinson, Krank, & McCully, 1982 참조). 조건부 보상 반응(통증 민감도 증가, 체온 감소 등)도 불편함을 유발할 수 있으므로 사용자는 이를 줄이기 위해 약물을 계속 사용하도록 동기를 부여할 수 있습니다. 이는 고전적 조건화가 약물 중독과 의존의 요인이 될 수 있는 여러 가지 방법 중 하나입니다.

고전적 단서의 마지막 효과는 지속적인 조작 행동에 동기를 부여한다는 것입니다(Balleine, 2005 참조). 예를 들어, 쥐가 조작적 조건화를 통해 레버를 누르면 약물이 나온다는 것을 학습했다면, '약물이 곧 나온다'는 신호(예: 레버 삐걱거리는 소리)가 있을 때 쥐는 이러한 신호가 없을 때(즉, 레버 삐걱거리는 소리가 없을 때)보다 레버를 더 열심히 누를 것입니다. 마찬가지로, 음식과 관련된 신호(예: 냄새)가 있으면 쥐(또는 과식하는 쥐)는 음식을 얻기 위해 더 열심히 일합니다. 마지막으로, 부정적인 신호(예: 두려움을 나타내는 신호)가 있는 경우에도 쥐, 사람 또는 다른 유기체는 트라우마로 이어질 수 있는 상황을 피하기 위해 더 열심히 노력할 것입니다. 따라서 고전적인 CS는 중요한 행동 현상에 기여할 수 있는 많은 영향을 미칩니다.

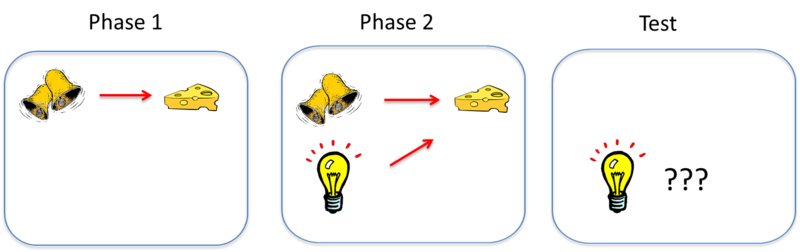

학습 과정

앞서 언급했듯이 고전적 조건화는 기본적인 학습 과정을 연구하는 방법을 제공합니다. 그러나 다소 직관적이지 않은 연구 결과에 따르면 CS와 US를 한 쌍으로 묶는 것만으로는 두 단어 사이의 연관성을 학습하는 데 충분하지 않다고 합니다. 차단이라는 효과를 생각해 보세요(Kamin, 1969 참조). 이 효과에서 동물은 먼저 하나의 CS(자극 A라고 함)를 US와 연관시키는 방법을 학습합니다. 위 그림에서 종소리(자극 A)는 먹이를 제시하는 것과 짝을 이룹니다. 이러한 연상이 학습되면 두 번째 단계에서는 두 번째 자극(자극 B)을 자극 A와 함께 제시하여 두 자극이 US와 함께 짝을 이루도록 합니다. 그림에서는 종을 울리는 동시에 조명이 추가되고 켜집니다. 그러나 동물은 이미 자극 A(종)와 음식 사이의 연관성을 학습했기 때문에 자극 B(불빛)와 음식 사이의 연관성은 학습하지 않습니다. 즉, 조건 반응은 자극 A를 제시하는 동안에만 발생하는데, 그 이유는 A에 B가 추가될 때 A의 이전 조건화가 B의 조건화를 "차단"하기 때문입니다. 자극 A는 이미 미국을 예측하고 있으므로 미국은 자극 B에서 발생할 때 놀라지 않습니다.

학습은 이러한 놀라움, 즉 조건화 시험에서 발생하는 것과 시험에 존재하는 단서에 의해 이미 예측된 것 사이의 불일치에 의존합니다. 고전적 조건화를 통해 무언가를 학습하려면 먼저 예측 오류, 즉 조건화된 자극이 예상한 결과로 이어지지 않을 가능성이 있어야 합니다. 종과 불빛의 예에서 종은 항상 음식이라는 보상으로 이어지기 때문에 불빛을 추가한다고 해서 교정할 수 있는 '예측 오류'는 없습니다. 그러나 연구자가 갑자기 먹이를 받기 위해 종소리와 불빛이 모두 발생하도록 요구한다면, 종소리만으로는 동물이 학습해야 하는 예측 오류가 발생할 것입니다.

차단 및 기타 관련 효과는 학습 프로세스가 중요한 이벤트에 대한 가장 유효한 예측 인자를 받아들이고 덜 유용한 인자는 무시하는 경향이 있음을 나타냅니다. 이는 현실 세계에서 흔히 볼 수 있는 현상입니다. 예를 들어 슈퍼마켓에서 세일 중인 제품에 큰 별 모양의 스티커를 붙인다고 가정해 보겠습니다. 큰 별 모양 스티커가 붙은 상품이 더 저렴하다는 것을 금방 알 수 있습니다. 하지만 이 스티커를 사용할 뿐만 아니라 할인을 나타내는 밝은 주황색 가격표도 사용하는 비슷한 슈퍼마켓에 들어간다고 상상해 보세요. 차단 덕분에(즉, 별 모양 스티커가 할인을 의미한다는 것을 이미 알고 있기 때문에) 색상 체계도 배울 필요가 없습니다. 별 모양 스티커는 알아야 할 모든 것을 알려주므로(즉, 할인에 대한 예측 오류가 없으므로) 색상 체계는 관련이 없습니다.

클래식 컨디셔닝은 CS와 US가 강렬하거나 두드러질 때 가장 강력합니다. 또한 CS와 US가 비교적 새롭고 유기체가 이전에 자주 노출되지 않은 경우에도 가장 좋습니다. 그리고 유기체의 생물학이 특정 CS와 US를 연관시키도록 준비된 경우 특히 더 강력합니다. 예를 들어, 쥐와 인간은 자연적으로 질병을 빛이나 음색이 아닌 맛과 연관시키는 경향이 있습니다. 음식은 대부분 맛으로 경험하기 때문에 특정 음식이 우리를 아프게 하는 경우, 다른 음식과 비슷할 수 있는 외형보다는 맛을 질병과 연관시키면 앞으로 그 음식을 피하게 되어 병에 걸리지 않을 확률이 높아집니다. 진화에 의해 형성된 이러한 분류 경향을 준비성이라고 합니다.

고전적 조건화의 강도에 영향을 미치는 요인은 여러 가지가 있으며, 이러한 요인은 많은 연구와 이론의 대상이 되어 왔습니다(Rescorla & Wagner, 1972; Pearce & Bouton, 2001 참조). 행동 신경과학자들도 고전적 조건화를 사용하여 학습에 관여하는 여러 가지 기본적인 두뇌 과정을 조사했습니다(Fanselow & Poulos, 2005; Thompson & Steinmetz, 2009 참조).

기존 학습 지우기

컨디셔닝 후, CS를 US 없이 반복적으로 제시하면 CS에 대한 반응이 사라질 수 있습니다. 이러한 효과를 소멸이라고 하며, 반응이 "소멸"된다고 합니다. 예를 들어, 파블로프가 종을 계속 울렸지만 그 후 개에게 먹이를 주지 않았다면, 종소리가 더 이상 먹이를 예측할 수 없기 때문에 결국 개는 CS(종소리)를 들었을 때 더 이상 침을 흘리는 CR(침 흘림)이 일어나지 않을 것입니다. 멸종은 여러 가지 이유로 중요합니다. 우선, 임상 심리학자들이 부적응적이고 원치 않는 행동을 제거하기 위해 사용하는 많은 치료법의 기초가 되기 때문입니다. 거미에 대한 극심한 공포증이 있는 사람을 예로 들면, 거미에 대한 체계적인 노출이 한 가지 접근 방법일 수 있습니다. 처음에는 거미라는 자극(예: 극심한 공포)을 볼 때마다 CR(예: 극심한 공포)을 경험하지만, 중립적인 조건의 거미 사진을 반복적으로 보여 주면 얼마 지나지 않아 자극이 더 이상 CR을 예측하지 않게 됩니다(즉, 거미가 더 이상 공포의 '단서' 역할을 하지 않는다는 것을 학습하여 거미를 볼 때 공포 반응이 나타나지 않게 됩니다). 여기서 혐오스러운 결과 없이 거미에 반복적으로 노출되면 멸종을 초래합니다.

그러나 심리학자들은 멸종에 대한 한 가지 중요한 사실을 받아들여야 합니다. 멸종이 반드시 원래의 학습을 파괴하지는 않는다는 것입니다(Bouton, 2004 참조). 예를 들어, 칠판 냄새를 중학교 방학의 고통과 강하게 연관시킨다고 상상해 보세요. 이제 수년 동안 칠판을 접한 후 칠판 냄새가 더 이상 구금의 고통(소멸의 예)을 떠올리지 않는다고 상상해 보십시오. 그러나 어느 날 새 건물에 처음 들어온 후 갑자기 칠판 냄새를 맡으면 구금의 고통이 다시 떠오릅니다. 이를 자발적 회복이라고 하는데, 소멸이 일어난 후 CS에 노출되는 시간이 경과한 후 때때로 CS에 재노출(예: 칠판 냄새)되면 다시 CR(예: 구금의 고통)을 불러일으킬 수 있습니다.

또 다른 관련 현상은 재생 효과입니다: 소멸 후 다른 방이나 장소와 같은 새로운 맥락에서 CS를 테스트하면 CR이 다시 나타날 수 있습니다. 칠판의 예에서, 칠판 냄새가 나지 않을 것으로 예상되는 새로운 건물에 들어가면 구금과 관련된 감각이 갑자기 새로워집니다. 이러한 효과는 소멸이 학습된 행동을 지우는 것이 아니라 억제하는 것으로 해석되며, 이러한 억제는 주로 학습된 맥락에서 표현됩니다(아래 주요 어휘 섹션의 "맥락" 참조).

그렇다고 해서 소멸이 행동 장애에 대한 나쁜 치료법이라는 의미는 아닙니다. 대신, 임상의는 학습에 대한 기초 연구를 사용하여 이러한 재발 효과를 없애는 데 도움을 줌으로써 그 효과를 높일 수 있습니다(Craske 외., 2008 참조). 예를 들어, 환자가 재발에 가장 취약할 수 있는 상황(예: 직장)에서 소멸 치료를 실시하는 것은 치료의 성공률을 높이기 위한 좋은 전략이 될 수 있습니다.

악기 컨디셔닝에 대해 알아야 할 유용한 정보

고전적 조건화의 강도에 영향을 미치는 대부분의 요소는 도구적 학습, 즉 우리의 행동을 그 결과와 연관시키는 법을 배우는 학습의 강도에도 영향을 미칩니다. 앞서 언급했듯이 강화자(또는 처벌자)가 "클수록" 학습이 더 강력해집니다. 그리고 도구적 행동이 더 이상 강화되지 않으면 그 행동도 소멸됩니다. 고전적 조건형성에 적용되는 대부분의 연상 학습 규칙은 도구적 학습에도 적용되지만, 도구적 학습에 대한 다른 사실도 알아두면 유용합니다.

자극을 제어하는 도구적 반응

아시다시피, 실험실에서 고전적인 조작자 반응은 쥐의 지렛대 누르기이며, 먹이로 강화됩니다. 그러나 특정 자극이 있을 때만 레버를 누르면 알갱이가 나오도록 설정할 수 있습니다. 예를 들어, 스키너 상자의 불이 켜져 있을 때만 레버 누르기를 강화할 수 있으며, 불이 꺼져 있으면 레버 누르기에서 음식이 나오지 않습니다. 쥐는 곧 불이 켜진 상태와 꺼진 상태를 구별하는 법을 배우고 불이 켜진 상태에서만 레버를 누릅니다(불이 꺼진 상태에서는 반응이 소멸됨). 일상 생활에서 신호등에서 회전 차선에서 기다리는 경우를 생각해 보세요. 녹색은 진행을 의미한다는 것을 알고 있지만 녹색 화살표가 있을 때만 방향을 전환할 수 있습니다. 이와 관련하여 조작자 행동은 이제 자극 제어하에 있다고합니다. 그리고 신호등과 마찬가지로 실제 세계에서도 자극 제어가 지배적일 것입니다.

조작자 반응을 제어하는 자극을 차별적 자극이라고 합니다. 이는 반응 또는 강화와 직접적으로 연관될 수 있습니다(아래 참조). 그러나 일반적으로 고전적 CS와 같은 방식으로 반응을 유도하지는 않습니다. 대신 조작자 반응의 '계기'를 마련하는 역할을 한다고 합니다. 예를 들어, 화가 앞에 놓인 캔버스는 그림을 그리는 행동을 유도하거나 그림을 그리도록 강요하지 않습니다. 캔버스는 그림을 그릴 수 있도록, 즉 그림을 그릴 수 있는 계기를 마련해 줍니다.

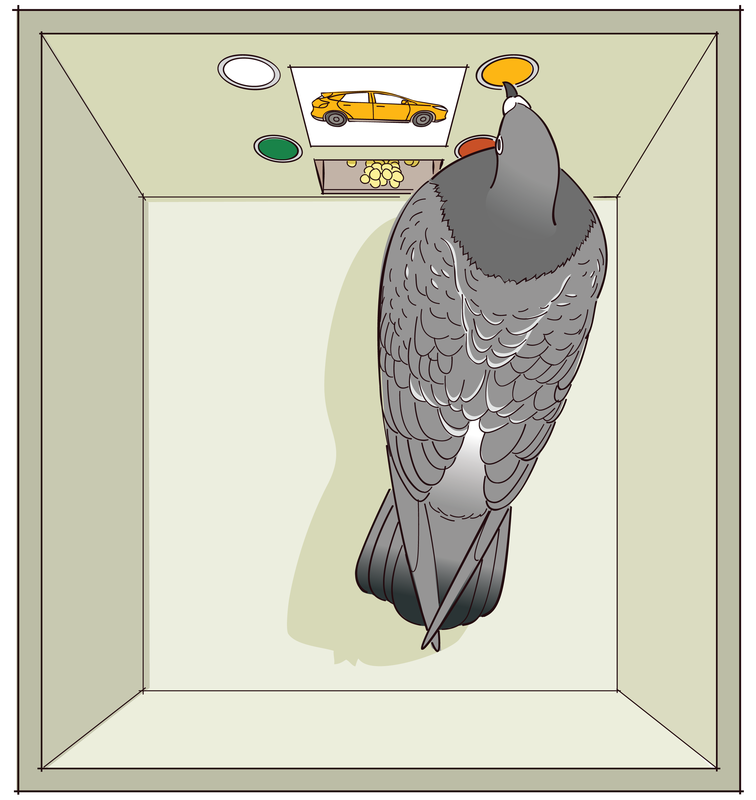

자극 제어 기술은 동물의 지각 및 기타 심리적 과정을 연구하기 위해 실험실에서 널리 사용됩니다. 예를 들어, 쥐가 빛을 볼 수 없다면 불이 켜지거나 꺼진 조건에 적절하게 반응하지 못할 것입니다. 이러한 논리에 따라 자극 제어 방법을 사용한 실험에서는 동물이 색을 얼마나 잘 보고, 초음파를 듣고, 자기장을 감지하는지를 테스트했습니다. 즉, 연구자들은 이러한 차별적 자극과 동물이 이미 이해하고 있는 자극(예: 레버를 누르는 것)을 짝을 지어 제시합니다. 이러한 방식으로 연구자들은 예를 들어 초음파가 재생될 때만 레버를 누르는 방법을 동물이 학습할 수 있는지 테스트할 수 있습니다.

이러한 방법은 "더 높은" 인지 과정을 연구하는 데에도 사용할 수 있습니다. 예를 들어, 비둘기는 꽃, 자동차, 의자 또는 사람의 사진을 미니어처 TV 화면에 보여주면 스키너 상자의 여러 버튼을 쪼는 방법을 배울 수 있습니다(Wasserman, 1995 참조). 꽃 이미지가 있으면 1번 버튼(다른 버튼은 없음)을 더 많이 쪼고, 의자 이미지가 있으면 2번 버튼을 더 많이 쪼는 식으로 학습이 강화됩니다. 비둘기는 이러한 구분법을 쉽게 학습할 수 있으며, 적절한 조건이 갖춰지면 처음 보는 꽃, 자동차, 의자, 사람 그림과 관련된 올바른 버튼을 쪼기도 합니다. 새들은 일련의 자극을 분류하는 법을 배웠습니다. 자극 제어 방법을 사용하여 이러한 분류가 어떻게 학습되는지 연구할 수 있습니다.

운영자 컨디셔닝에는 선택권이 포함됩니다.

조작적 조건화에 대해 알아야 할 또 다른 사항은 반응이 항상 다른 행동보다 한 가지 행동을 선택해야 한다는 것입니다. 목요일 밤에 술집에 간 학생은 집에 남아 공부하는 대신 술을 마시는 것을 선택합니다. 쥐는 잠을 자거나 상자 뒤쪽의 귀를 긁는 대신 레버를 누르는 것을 선택합니다. 이러한 대체 행동은 각각 고유한 강화제와 연관되어 있습니다. 그리고 특정 행동을 수행하는 경향은 그 행동에 대해 획득한 강화제와 대체 행동에 대해 획득한 강화제 모두에 따라 달라집니다.

이 아이디어를 조사하기 위해 스키너 상자에서는 쥐에게 두 개의 레버(또는 비둘기에게 두 개의 버튼)를 제공하고 각각에 고유한 강화 또는 보상률을 부여하여 선택에 대해 연구해 왔습니다. 이와 같은 상황에서 선택에 대한 철저한 연구를 통해 정량적 효과의 법칙(Herrnstein, 1970 참조)이라는 규칙이 만들어졌는데, 이는 정량적으로 자세히 설명하지 않아도 이해할 수 있습니다: 이 법칙은 한 행동을 강화하는 효과는 그 행동의 대안에 대해 얼마나 많은 강화를 받았는지에 따라 결정적으로 달라진다는 사실을 인정합니다. 예를 들어, 비둘기가 하나의 불빛을 쪼면 두 개의 먹이를 얻을 수 있고 다른 불빛은 하나만 얻을 수 있다는 것을 학습한 경우, 비둘기는 첫 번째 불빛만 쪼게 될 것입니다. 하지만 첫 번째 불빛이 두 번째 불빛보다 도달하는 데 더 힘들다면 어떻게 될까요? 에너지 비용이 먹이의 보너스보다 더 클까요? 아니면 여분의 먹이가 그만한 가치가 있을까요? 일반적으로 환경에 대체 강화제가 많으면 주어진 강화제는 덜 강화됩니다. 따라서 직장에서의 성취감이나 가족의 사랑과 같은 다른 강화제가 주변에 가득하다면 술, 섹스 또는 마약은 덜 강력한 강화제가 될 수 있습니다.

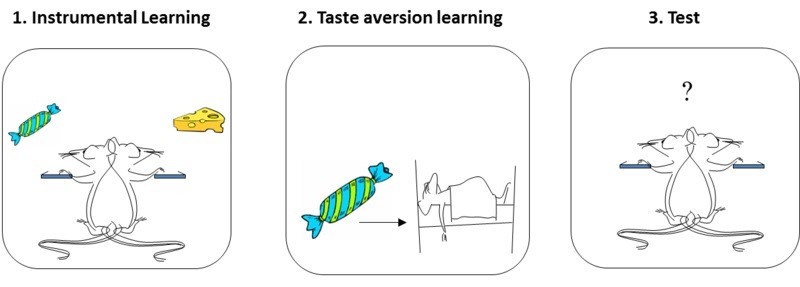

도구 학습에서의 인지

현대 연구에 따르면 강화제는 손다이크의 원래 견해처럼 단순히 행동의 결과를 강화하거나 '찍어내는' 것 이상의 역할을 합니다. 대신, 동물은 각 행동의 구체적인 결과에 대해 학습하고 현재 그 결과를 얼마나 원하는지, 즉 '가치'에 따라 행동을 수행하게 됩니다.

이 개념은 강화제 평가절하 효과라는 현상으로 가장 잘 설명됩니다(Colwill & Rescorla, 1986 참조). 쥐는 먼저 두 가지 도구적 행동(예: 왼쪽 레버와 오른쪽 레버 누르기)을 수행하도록 훈련받으며, 각각 다른 강화제(예: 단 자당 용액과 음식 알갱이)와 짝을 이룹니다. 이 훈련이 끝나면 쥐는 자당 용액과 음식 펠렛을 번갈아 가며 두 레버를 모두 누르는 경향이 있습니다. 두 번째 단계에서는 강화제 중 하나(예: 자당)를 질병과 별도로 짝을 이룹니다. 이를 통해 수크로오스에 대한 미각 혐오를 조절합니다. 마지막 실험에서는 쥐를 스키너 상자로 돌려보내고 두 레버 중 하나를 자유롭게 누르도록 합니다. 이 테스트에서는 강화제가 제시되지 않으므로(즉, 레버를 눌러도 자당이나 먹이가 나오지 않음), 테스트 중 행동은 쥐가 이전에 학습한 내용을 기억한 결과일 뿐입니다. 여기서 중요한 점은 쥐가 이전에 혐오감을 느꼈던 강화제를 생성했던 반응을 수행하지 않기로 선택한다는 것입니다(예: 자당 레버를 누르지 않음). 이는 쥐가 각 반응과 관련된 강화제를 학습하고 기억하고 있으며, 그 지식과 강화제가 이제 "나쁘다"는 지식을 결합할 수 있다는 것을 의미합니다. 강화제는 단순히 반응에 도장을 찍는 것이 아니라 그 이상의 것을 학습합니다. 이러한 행동은 관련 목표의 현재 가치(즉, 쥐가 강화제를 얼마나 원하는지/원하지 않는지)에 영향을 받기 때문에 "목표 지향적"(Dickinson & Balleine, 1994 참조)이라고 합니다.

그러나 쥐가 도구적 행동을 자주 반복적으로 수행하면 상황이 더 복잡해질 수 있습니다. 즉, 쥐가 수개월 동안 각 레버를 누르는 것의 가치를 학습했다면, 레버를 누르는 행위는 자동적이고 일상적인 것이 됩니다. 그리고 여기서 한 번 목표 지향적인 행동(즉, 쥐가 자당/먹이를 얻기 위해 레버를 누르는 행동)은 습관이 될 수 있습니다. 따라서 쥐가 레버를 누르는 행동을 수개월 동안 수행하면(그러한 행동이 습관이 되면), 자당이 다시 질병과 결합하더라도 쥐는 계속해서 레버를 누르게 됩니다(Holland, 2004 참조). 모든 연습이 끝나면 도구적 반응(레버 누르기)은 더 이상 강화제 평가 절하에 민감하지 않습니다. 쥐는 이 레버에서 나오는 자당이 쥐를 아프게 한다는 사실에 관계없이 계속 자동으로 반응합니다.

습관은 인간의 경험에서 매우 일반적이며 유용 할 수 있습니다. 아침에 커피를 만드는 방법이나 양치질하는 방법을 매일 다시 배울 필요가 없습니다. 도구적인 행동은 결국 습관화되어 다른 일에 대해 자유롭게 생각하면서 일을 완수할 수 있게 해줍니다.

클래식과 악기 컨디셔닝의 결합

고전적 조건화와 조작적 조건화는 일반적으로 별도로 연구됩니다. 그러나 실험실 밖에서는 거의 항상 동시에 발생합니다. 예를 들어, 술을 마시거나 과식하는 것에 대해 강화된 사람은 술집, 친구들, 식당 또는 TV 앞 소파 등 특정 자극이 있을 때 이러한 행동을 학습합니다. 이러한 자극은 강화자와의 연관성에도 사용할 수 있습니다. 이런 식으로 고전적 조건화와 조작적 조건화는 항상 서로 얽혀 있습니다.

아래 그림은 이 개념을 요약한 것으로, 이 모듈에서 논의한 내용을 복습하는 데 도움이 됩니다. 일반적으로 강화 또는 처벌 조작 반응(R)은 어떤 자극 또는 자극 집합(S)이 있을 때 결과(O)와 짝을 이룹니다.

그림은 이 매우 일반적인 시나리오에서 학습할 수 있는 연상 유형을 보여줍니다. 우선, 유기체는 반응과 결과(R - O)를 연관시키는 방법을 학습하게 됩니다. 이것이 도구적 조건화입니다. 여기서 학습 과정은 놀라움과 예측 오류에 중점을 둔 고전적 조건화와 유사할 것입니다. 그리고 강화자 평가절하 효과를 고려할 때 논의했듯이, R - O가 학습되면 유기체는 원하는 결과나 가치가 있는 경우 반응을 수행할 준비가 됩니다. 강화의 가치는 상황의 다른 행동에 대해 획득한 다른 강화에 의해서도 영향을 받을 수 있습니다. 이러한 요소들이 도구 학습의 핵심입니다.

둘째, 유기체는 자극을 강화 결과(S - O)와 연관시키는 방법을 배울 수도 있습니다. 이것은 고전적 조건화 구성 요소이며, 앞서 살펴본 바와 같이 행동에 많은 영향을 미칠 수 있습니다. 우선, 자극은 유기체가 강화제를 준비하는 데 도움이되는 반응 시스템을 불러 일으킬 것입니다 (그림에 표시되지 않음): 마시는 사람은 체온의 변화를 겪을 수 있고, 먹는 사람은 침을 흘리고 인슐린 분비가 증가 할 수 있습니다. 또한 자극은 접근(결과가 긍정적인 경우) 또는 후퇴(결과가 부정적인 경우)를 불러일으킬 수 있습니다. 자극을 제시하면 도구적 반응도 유발할 수 있습니다.

다이어그램의 세 번째 연관성은 자극과 반응(S - R) 사이의 연관성입니다. 앞서 설명한 것처럼, 많은 연습을 하면 자극이 직접 반응을 이끌어내기 시작할 수 있습니다. 이것은 습관 학습으로, 행동과 결과 사이의 관계 및 결과의 현재 값에 대한 많은 정신적 처리 없이 반응이 비교적 자동으로 발생합니다.

그림의 마지막 연결 고리는 자극과 반응-결과 연관[S - (R - O)]입니다. 자극은 단순히 R 또는 O와 연관성을 맺는 것 이상으로, 이제 R - O 관계가 유효하다는 신호를 보낼 수 있습니다. 이것이 바로 자극이 조작적 반응의 '계기'가 될 수 있다는 말의 의미입니다: 자극은 반응-강화자 관계의 계기를 마련해 줍니다. 이 메커니즘을 통해 화가는 올바른 도구와 캔버스가 제공하는 기회가 주어지면 그림을 그리기 시작할 수 있습니다. 캔버스는 이론적으로 그림을 그리는 행동이 이제 긍정적인 결과에 의해 강화될 것이라는 신호를 보냅니다.

이 그림은 자신, 가족 또는 친구에게서 관찰되는 거의 모든 학습된 행동을 이해하는 데 사용할 수 있는 프레임워크를 제공합니다. 더 깊이 이해하고 싶다면 앞으로 학습에 관한 강의를 수강하여 고전적 학습, 도구적 학습, 습관 학습, 상황 설정이 실제로 어떻게 작동하고 상호 작용하는지에 대해 더 깊이 알아보세요.

관찰 학습

모든 형태의 학습이 고전적 조건화와 조작적 조건화에 의해 전적으로 설명되는 것은 아닙니다. 한 어린이가 놀이터에서 게임을 하고 있는 아이들에게 다가간다고 상상해 보세요. 게임은 재미있어 보이지만 새롭고 낯선 게임입니다. 아이는 바로 게임에 참여하지 않고 가만히 앉아 다른 아이들이 한두 라운드 플레이하는 것을 지켜봅니다. 다른 아이들을 관찰하면서 아이는 게임을 하는 동안 그들이 어떻게 행동하는지를 기록합니다. 다른 아이들의 행동을 관찰함으로써 아이는 게임의 규칙과 게임을 잘하기 위한 몇 가지 전략까지 파악할 수 있습니다. 이를 관찰 학습이라고 합니다.

관찰 학습은 알버트 반두라의 사회 학습 이론(Bandura, 1977)의 한 구성 요소로, 개인이 타인의 주요 행동을 관찰함으로써 새로운 반응을 배울 수 있다고 가정합니다. 관찰 학습은 반드시 강화를 필요로 하는 것은 아니며, 사회적 모델이라고 하는 다른 사람의 존재에 의존합니다. 사회적 모델은 일반적으로 관찰자에 비해 지위나 권위가 높은 사람으로, 부모, 교사, 경찰관 등이 그 예입니다. 위의 예에서 이미 게임 방법을 알고 있는 어린이는 관찰자와 같은 나이임에도 불구하고 권위자, 즉 사회적 모델이라고 생각할 수 있습니다. 사회적 모델이 어떻게 행동하는지를 관찰함으로써 개인은 특정 상황에서 어떻게 행동해야 하는지 배울 수 있습니다. 관찰 학습의 다른 예로는 저녁 식사 테이블에서 부모를 보면서 냅킨을 무릎에 놓는 법을 배우는 아이, 핫도그 가판대에서 다른 고객을 관찰하면서 케첩과 머스타드를 어디에 두는지 배우는 고객 등이 있을 수 있습니다.

반두라는 관찰 학습 과정을 네 가지 부분으로 구성한다고 이론화했습니다. 첫 번째는 주의 집중으로, 간단히 말해 학습을 위해서는 관찰 대상에 주의를 기울여야 합니다. 두 번째는 기억으로, 학습을 위해서는 관찰하고 있는 행동을 기억에 유지할 수 있어야 하며, 관찰 학습의 세 번째 부분인 시작은 학습자가 학습한 행동을 실행(또는 시작)할 수 있어야 한다는 것을 인정합니다. 마지막으로 관찰자는 관찰 학습에 참여할 동기가 있어야 합니다. 이 비네트에서는 관찰 학습에 제대로 참여하려면 아이가 게임을 하는 방법을 배우고 싶어 해야 합니다.

연구자들은 관찰 학습을 탐구하기 위해 수많은 실험을 수행했으며, 그 중 가장 유명한 실험은 알버트 반두라의 "보보 인형 실험"입니다.

이 실험(반두라, 로스, 로스 1961)에서 반두라는 어린이들에게 성인 사회 모델이 광대 인형('보보')과 상호작용하는 모습을 개별적으로 관찰하게 했습니다. 한 그룹의 어린이에게 성인은 보보를 주먹으로 때리고, 발로 차고, 던지고, 심지어 장난감 망치로 얼굴을 때리는 등 공격적으로 보보와 상호작용했습니다. 또 다른 어린이 그룹은 어른이 다른 장난감과 상호작용하는 모습을 지켜보았지만 보보에 대한 공격성은 보이지 않았습니다. 두 경우 모두 어른은 자리를 떠났고 아이들은 스스로 보보와 상호작용할 수 있었습니다. 반두라는 공격적 사회 모델에 노출된 아이들이 비공격적 모델에 노출된 아이들에 비해 보보를 때리거나 발로 차는 등 공격적으로 행동할 가능성이 훨씬 더 높다는 사실을 발견했습니다. 연구진은 공격적인 그룹에 속한 아이들이 성인 사회 모델의 행동을 관찰하여 보보에 대한 공격적인 행동이 용인될 수 있다고 판단했다고 결론지었습니다.

반두라의 첫 번째 실험에서 아동의 행동을 유도하기 위해 강화가 필요하지 않았지만, 관찰 학습에서 결과가 중요한 역할을 한다는 것을 인정하는 것이 중요합니다. 이 연구의 후속 연구(Bandura, Ross, & Ross, 1963)에서는 공격성 그룹의 아동이 성인 모델이 보보에 대한 공격으로 처벌을 받는 것을 목격한 경우 덜 공격적인 행동을 보인다는 사실을 입증했습니다. 반두라는 이 과정을 대리 강화라고 불렀는데, 이는 아동이 강화나 처벌을 직접 경험하지는 않았지만 이를 관찰함으로써 영향을 받았기 때문입니다.

결론

지금까지 우리가 어떻게 행동하고 주변 세계와 상호작용하는 법을 배우는지에 대한 세 가지 주요 설명에 대해 살펴봤습니다. 자신의 경험을 고려할 때 이러한 이론이 자신에게 얼마나 잘 적용되나요? 자신의 패션 감각에 대해 생각해 보면, 다른 사람들이 칭찬한 옷을 선택하는 경향이 있다는 것을 알게 될 수도 있습니다(조작적 조건화). 또는 최근에 가본 새로운 레스토랑을 떠올리면서 광고에서 행복한 음악이 흘러나와서 그 레스토랑을 선택했다는 것을 깨달았을 수도 있습니다(클래식 조건화). 또는 다른 사람들이 지각했을 때 벌을 받는 것을 본 이후로 과제를 항상 제시간에 할 수 있게 되었을 수도 있습니다(관찰 학습). 활동, 행동 또는 반응에 관계없이 이 모듈에 제시된 이론 중 하나에 근거하여 그 활동을 하기로 한 '결정'을 설명할 수 있을 가능성이 높습니다.

Outside Resources

- Article: Rescorla, R. A. (1988). Pavlovian conditioning: It’s not what you think it is. American Psychologist, 43, 151–160.

- Book: Bouton, M. E. (2007). Learning and behavior: A contemporary synthesis. Sunderland, MA: Sinauer Associates.

- Book: Bouton, M. E. (2009). Learning theory. In B. J. Sadock, V. A. Sadock, & P. Ruiz (Eds.), Kaplan & Sadock’s comprehensive textbook of psychiatry (9th ed., Vol. 1, pp. 647–658). New York, NY: Lippincott Williams & Wilkins.

- Book: Domjan, M. (2010). The principles of learning and behavior (6th ed.). Belmont, CA: Wadsworth.

- Video: Albert Bandura discusses the Bobo Doll Experiment.

Discussion Questions

- Describe three examples of Pavlovian (classical) conditioning that you have seen in your own behavior, or that of your friends or family, in the past few days.

- Describe three examples of instrumental (operant) conditioning that you have seen in your own behavior, or that of your friends or family, in the past few days.

- Drugs can be potent reinforcers. Discuss how Pavlovian conditioning and instrumental conditioning can work together to influence drug taking.

- In the modern world, processed foods are highly available and have been engineered to be highly palatable and reinforcing. Discuss how Pavlovian and instrumental conditioning can work together to explain why people often eat too much.

- How does blocking challenge the idea that pairings of a CS and US are sufficient to cause Pavlovian conditioning? What is important in creating Pavlovian learning?

- How does the reinforcer devaluation effect challenge the idea that reinforcers merely “stamp in” the operant response? What does the effect tell us that animals actually learn in operant conditioning?

- With regards to social learning do you think people learn violence from observing violence in movies? Why or why not?

- What do you think you have learned through social learning? Who are your social models?

Vocabulary

- Blocking

- In classical conditioning, the finding that no conditioning occurs to a stimulus if it is combined with a previously conditioned stimulus during conditioning trials. Suggests that information, surprise value, or prediction error is important in conditioning.

- Categorize

- To sort or arrange different items into classes or categories.

- Classical conditioning

- The procedure in which an initially neutral stimulus (the conditioned stimulus, or CS) is paired with an unconditioned stimulus (or US). The result is that the conditioned stimulus begins to elicit a conditioned response (CR). Classical conditioning is nowadays considered important as both a behavioral phenomenon and as a method to study simple associative learning. Same as Pavlovian conditioning.

- Conditioned compensatory response

- In classical conditioning, a conditioned response that opposes, rather than is the same as, the unconditioned response. It functions to reduce the strength of the unconditioned response. Often seen in conditioning when drugs are used as unconditioned stimuli.

- Conditioned response (CR)

- The response that is elicited by the conditioned stimulus after classical conditioning has taken place.

- Conditioned stimulus (CS)

- An initially neutral stimulus (like a bell, light, or tone) that elicits a conditioned response after it has been associated with an unconditioned stimulus.

- Context

- Stimuli that are in the background whenever learning occurs. For instance, the Skinner box or room in which learning takes place is the classic example of a context. However, “context” can also be provided by internal stimuli, such as the sensory effects of drugs (e.g., being under the influence of alcohol has stimulus properties that provide a context) and mood states (e.g., being happy or sad). It can also be provided by a specific period in time—the passage of time is sometimes said to change the “temporal context.”

- Discriminative stimulus

- In operant conditioning, a stimulus that signals whether the response will be reinforced. It is said to “set the occasion” for the operant response.

- Extinction

- Decrease in the strength of a learned behavior that occurs when the conditioned stimulus is presented without the unconditioned stimulus (in classical conditioning) or when the behavior is no longer reinforced (in instrumental conditioning). The term describes both the procedure (the US or reinforcer is no longer presented) as well as the result of the procedure (the learned response declines). Behaviors that have been reduced in strength through extinction are said to be “extinguished.”

- Fear conditioning

- A type of classical or Pavlovian conditioning in which the conditioned stimulus (CS) is associated with an aversive unconditioned stimulus (US), such as a foot shock. As a consequence of learning, the CS comes to evoke fear. The phenomenon is thought to be involved in the development of anxiety disorders in humans.

- Goal-directed behavior

- Instrumental behavior that is influenced by the animal’s knowledge of the association between the behavior and its consequence and the current value of the consequence. Sensitive to the reinforcer devaluation effect.

- Habit

- Instrumental behavior that occurs automatically in the presence of a stimulus and is no longer influenced by the animal’s knowledge of the value of the reinforcer. Insensitive to the reinforcer devaluation effect.

- Instrumental conditioning

- Process in which animals learn about the relationship between their behaviors and their consequences. Also known as operant conditioning.

- Law of effect

- The idea that instrumental or operant responses are influenced by their effects. Responses that are followed by a pleasant state of affairs will be strengthened and those that are followed by discomfort will be weakened. Nowadays, the term refers to the idea that operant or instrumental behaviors are lawfully controlled by their consequences.

- Observational learning

- Learning by observing the behavior of others.

- Operant

- A behavior that is controlled by its consequences. The simplest example is the rat’s lever-pressing, which is controlled by the presentation of the reinforcer.

- Operant conditioning

- See instrumental conditioning.

- Pavlovian conditioning

- See classical conditioning.

- Prediction error

- When the outcome of a conditioning trial is different from that which is predicted by the conditioned stimuli that are present on the trial (i.e., when the US is surprising). Prediction error is necessary to create Pavlovian conditioning (and associative learning generally). As learning occurs over repeated conditioning trials, the conditioned stimulus increasingly predicts the unconditioned stimulus, and prediction error declines. Conditioning works to correct or reduce prediction error.

- Preparedness

- The idea that an organism’s evolutionary history can make it easy to learn a particular association. Because of preparedness, you are more likely to associate the taste of tequila, and not the circumstances surrounding drinking it, with getting sick. Similarly, humans are more likely to associate images of spiders and snakes than flowers and mushrooms with aversive outcomes like shocks.

- Punisher

- A stimulus that decreases the strength of an operant behavior when it is made a consequence of the behavior.

- Quantitative law of effect

- A mathematical rule that states that the effectiveness of a reinforcer at strengthening an operant response depends on the amount of reinforcement earned for all alternative behaviors. A reinforcer is less effective if there is a lot of reinforcement in the environment for other behaviors.

- Reinforcer

- Any consequence of a behavior that strengthens the behavior or increases the likelihood that it will be performed it again.

- Reinforcer devaluation effect

- The finding that an animal will stop performing an instrumental response that once led to a reinforcer if the reinforcer is separately made aversive or undesirable.

- Renewal effect

- Recovery of an extinguished response that occurs when the context is changed after extinction. Especially strong when the change of context involves return to the context in which conditioning originally occurred. Can occur after extinction in either classical or instrumental conditioning.

- The theory that people can learn new responses and behaviors by observing the behavior of others.

- Authorities that are the targets for observation and who model behaviors.

- Spontaneous recovery

- Recovery of an extinguished response that occurs with the passage of time after extinction. Can occur after extinction in either classical or instrumental conditioning.

- Stimulus control

- When an operant behavior is controlled by a stimulus that precedes it.

- Taste aversion learning

- The phenomenon in which a taste is paired with sickness, and this causes the organism to reject—and dislike—that taste in the future.

- Unconditioned response (UR)

- In classical conditioning, an innate response that is elicited by a stimulus before (or in the absence of) conditioning.

- Unconditioned stimulus (US)

- In classical conditioning, the stimulus that elicits the response before conditioning occurs.

- Vicarious reinforcement

- Learning that occurs by observing the reinforcement or punishment of another person.

References

- Balleine, B. W. (2005). Neural basis of food-seeking: Affect, arousal, and reward in corticostratolimbic circuits. Physiology & Behavior, 86, 717–730.

- Bandura, A. (1977). Social learning theory. Englewood Cliffs, NJ: Prentice Hall

- Bandura, A., Ross, D., Ross, S (1963). Imitation of film-mediated aggressive models. Journal of Abnormal and Social Psychology 66(1), 3 - 11.

- Bandura, A.; Ross, D.; Ross, S. A. (1961). "Transmission of aggression through the imitation of aggressive models". Journal of Abnormal and Social Psychology 63(3), 575–582.

- Bernstein, I. L. (1991). Aversion conditioning in response to cancer and cancer treatment. Clinical Psychology Review, 11, 185–191.

- Bouton, M. E. (2004). Context and behavioral processes in extinction. Learning & Memory, 11, 485–494.

- Colwill, R. M., & Rescorla, R. A. (1986). Associative structures in instrumental learning. In G. H. Bower (Ed.), The psychology of learning and motivation, (Vol. 20, pp. 55–104). New York, NY: Academic Press.

- Craske, M. G., Kircanski, K., Zelikowsky, M., Mystkowski, J., Chowdhury, N., & Baker, A. (2008). Optimizing inhibitory learning during exposure therapy. Behaviour Research and Therapy, 46, 5–27.

- Dickinson, A., & Balleine, B. W. (1994). Motivational control of goal-directed behavior. Animal Learning & Behavior, 22, 1–18.

- Fanselow, M. S., & Poulos, A. M. (2005). The neuroscience of mammalian associative learning. Annual Review of Psychology, 56, 207–234.

- Herrnstein, R. J. (1970). On the law of effect. Journal of the Experimental Analysis of Behavior, 13, 243–266.

- Holland, P. C. (2004). Relations between Pavlovian-instrumental transfer and reinforcer devaluation. Journal of Experimental Psychology: Animal Behavior Processes, 30, 104–117.

- Kamin, L. J. (1969). Predictability, surprise, attention, and conditioning. In B. A. Campbell & R. M. Church (Eds.), Punishment and aversive behavior (pp. 279–296). New York, NY: Appleton-Century-Crofts.

- Mineka, S., & Zinbarg, R. (2006). A contemporary learning theory perspective on the etiology of anxiety disorders: It’s not what you thought it was. American Psychologist, 61, 10–26.

- Pearce, J. M., & Bouton, M. E. (2001). Theories of associative learning in animals. Annual Review of Psychology, 52, 111–139.

- Rescorla, R. A., & Wagner, A. R. (1972). A theory of Pavlovian conditioning: Variations in the effectiveness of reinforcement and nonreinforcement. In A. H. Black & W. F. Prokasy (Eds.), Classical conditioning II: Current research and theory (pp. 64–99). New York, NY: Appleton-Century-Crofts.

- Scalera, G., & Bavieri, M. (2009). Role of conditioned taste aversion on the side effects of chemotherapy in cancer patients. In S. Reilly & T. R. Schachtman (Eds.), Conditioned taste aversion: Behavioral and neural processes (pp. 513–541). New York, NY: Oxford University Press.

- Siegel, S. (1989). Pharmacological conditioning and drug effects. In A. J. Goudie & M. Emmett-Oglesby (Eds.), Psychoactive drugs (pp. 115–180). Clifton, NY: Humana Press.

- Siegel, S., Hinson, R. E., Krank, M. D., & McCully, J. (1982). Heroin “overdose” death: Contribution of drug associated environmental cues. Science, 216, 436–437.

- Spreat, S., & Spreat, S. R. (1982). Learning principles. In V. Voith & P. L. Borchelt (Eds.), Veterinary clinics of North America: Small animal practice (pp. 593–606). Philadelphia, PA: W. B. Saunders.

- Thompson, R. F., & Steinmetz, J. E. (2009). The role of the cerebellum in classical conditioningof discrete behavioral responses. Neuroscience, 162, 732–755.

- Timberlake, W. L. (2001). Motivational modes in behavior systems. In R. R. Mowrer & S. B. Klein (Eds.), Handbook of contemporary learning theories (pp. 155–210). Mahwah, NJ: Lawrence Erlbaum Associates, Inc.

- Wasserman, E. A. (1995). The conceptual abilities of pigeons. American Scientist, 83, 246–255.

Authors

Mark E. BoutonMark E. Bouton is the Lawson Professor of Psychology at the University of Vermont. His research on learning and extinction is internationally known. He is a Fellow of several scientific organizations, including APA, APS, and the Society of Experimental Psychologists. He was recently awarded the Gantt Medal from the Pavlovian Society.

Mark E. BoutonMark E. Bouton is the Lawson Professor of Psychology at the University of Vermont. His research on learning and extinction is internationally known. He is a Fellow of several scientific organizations, including APA, APS, and the Society of Experimental Psychologists. He was recently awarded the Gantt Medal from the Pavlovian Society.

Creative Commons License

Conditioning and Learning by Mark E. Bouton is licensed under a Creative Commons Attribution-NonCommercial-ShareAlike 4.0 International License. Permissions beyond the scope of this license may be available in our Licensing Agreement.

Conditioning and Learning by Mark E. Bouton is licensed under a Creative Commons Attribution-NonCommercial-ShareAlike 4.0 International License. Permissions beyond the scope of this license may be available in our Licensing Agreement.